O crescimento galopante do volume de dados no ambiente corporativo é uma preocupação de longa data. Mas esse quadro se agravou significativamente com a transformação digital, apoiada em tecnologias disruptivas que estão provocando um avanço exponencial de dados estruturados e não estruturados.

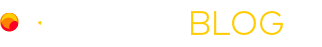

De acordo com o instituto de pesquisa global Gartner, os líderes de TI precisam adotar Big Data e tecnologias emergentes em seu entorno para operacionalizar a ciência de dados em suas empresas. Para isso, o instituto ressalta a importância de planejar o armazenamento e o gerenciamento de mais dados, pois a tendência é que o volume não pare de crescer.

Para que os dados sejam valiosos, eles devem ser de alta qualidade, o que significa que será necessário muito armazenamento. Tecnologias disruptivas, como aprendizado profundo (deep learning), exigem dados de alta qualidade e as áreas de TI serão responsáveis pelo gerenciamento e pelo armazenamento dessas informações, além de disponibilizar os dados corretos para diversas áreas da empresa.

Segundo levantamento da McKinsey, consultoria global, 23% das corporações já utilizam estratégias efetivamente conectadas ao universo dos dados e de IA. Além disso, segundo o Gartner, as que investem em Big Data são cinco vezes mais propensas a tomar decisões mais rápidas do que a concorrência, demonstrando grande vantagem competitiva.

Nesse cenário, portanto, o Big Data ganha cada vez mais importância. Se pararmos dez minutos para pensar na tecnologia, somente neste espaço de tempo, são gerados mais dados do que a humanidade totalizou em 2013. O crescimento é imensurável.

Isso porque os dados surgem de variadas fontes. Eles são gerados quando falamos ao telefone, usando o cartão de crédito, ao colocar combustível no carro, enviando e-mails, fazendo anotações digitais, tirando fotos, ao gravar um vídeo de aniversário, comprando o bilhete do transporte, assistindo a treinamentos na internet e em uma infinidade de outras atividades. Assim, é possível imaginar como essa avalanche irrefreável é alimentada.

Os smartphones, por exemplo, têm ao menos dez sensores que geram dados por meio de GPS, câmera de frente e verso, giroscópio, WiFi, microfone, sensor de luz ambiente, bluetooth, entre outros recursos.

Esse tsunami de dados variados e de diferentes formatos também recebe o nome de “internet de eventos” e são divididos em quatro grandes grupos:

1- Internet dos conteúdos (Google, Wikipedia …)

2- Internet das pessoas (Twitter, Facebook, Snapshat …)

3- Internet das coisas – IoT (sensor de temperatura, sensor de luz, smart TVs e vários tipos de “devices”…)

4 -Internet dos lugares (Android, iPhone, tablet …)

Quando falamos de Big Data, portanto, estamos nos referindo a um volume de dados vindos da internet de eventos e que crescem exponencialmente. Para armazenar, entender e transformar essa quantidade de eventos em informação estratégica é necessário andar de mãos dadas com a tecnologia. Toda a infraestrutura de TI precisa atender a essa crescente demanda por recursos.

Por incrível que pareça, essa procura crescente por mais recursos foi prevista em 1965 e dizia que o poder de processamento dos computadores dobraria a cada 18 meses – É a conhecida “Lei de Moore”.

Aplicando a mesma lei para dados, é possível dizer que a cada 18 meses os números de dados gerados dobra. A consequência? Algumas são necessidade de mais poder de processamento, mais memória, mais capacidade de armazenamento e mais negócios e oportunidades digitais.

A revolução digital seguirá proporcionando um oceano de oportunidades, mas para surfar nessa onda é preciso entender e garimpar as informações geradas pela internet de eventos. Para isso, é necessário a empresa dobrar sua capacidade tecnológica a cada dois anos para continuar competitiva. Esta é uma das grandes razões de as corporações do mundo inteiro iniciarem a sua jornada para cloud. É o que a equipe da Compasso UOL tem comprovado e possibilitado a empresas de variados setores da economia.